Веб-сканеры с искусственным интеллектом разрушают Интернет

Веб-сканеры с искусственным интеллектом на бумаге кажутся отличной идеей. Кому не нужен веб-сканер, который может автоматически индексировать информацию и динамически корректировать правила SEO? Хотя это кажется мечтой, накладные расходы убивают веб-страницы и расстраивают системных администраторов.

Что такое веб-сканеры с искусственным интеллектом?

Веб-сканеры, также известные как веб-пауки или боты, представляют собой автоматизированные программы, предназначенные для просмотра Интернета и сбора информации с различных веб-сайтов. Они систематически посещают веб-страницы, читают их контент и индексируют релевантные данные для поисковых систем, таких как Google. Переходя по ссылкам с одной страницы на другую, сканеры обеспечивают наличие в поисковых системах актуальной информации, позволяя пользователям быстро и эффективно находить нужный им контент. Этот процесс важен для поддержания функциональности поисковых систем.

Помимо поисковых систем, компании используют веб-сканеры для различных целей, включая анализ данных и исследование рынка. Эти боты могут собирать информацию о конкурентах, отслеживать цены и собирать пользовательский контент. Однако не все краулеры действуют ответственно; некоторые могут игнорировать правила веб-сайта или перегружать серверы чрезмерными запросами. Итак, если веб-сканеры так важны в нашей цифровой инфраструктуре, почему их улучшение с помощью ИИ может быть плохим? Все это связано с влиянием, которое веб-сканеры с искусственным интеллектом оказывают на внутреннюю инфраструктуру веб-сайтов.

Как веб-краулеры с искусственным интеллектом перегружают серверы

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

ВИРОЖЕ ПАТИ / Shutterstock.com

ВИРОЖЕ ПАТИ / Shutterstock.com

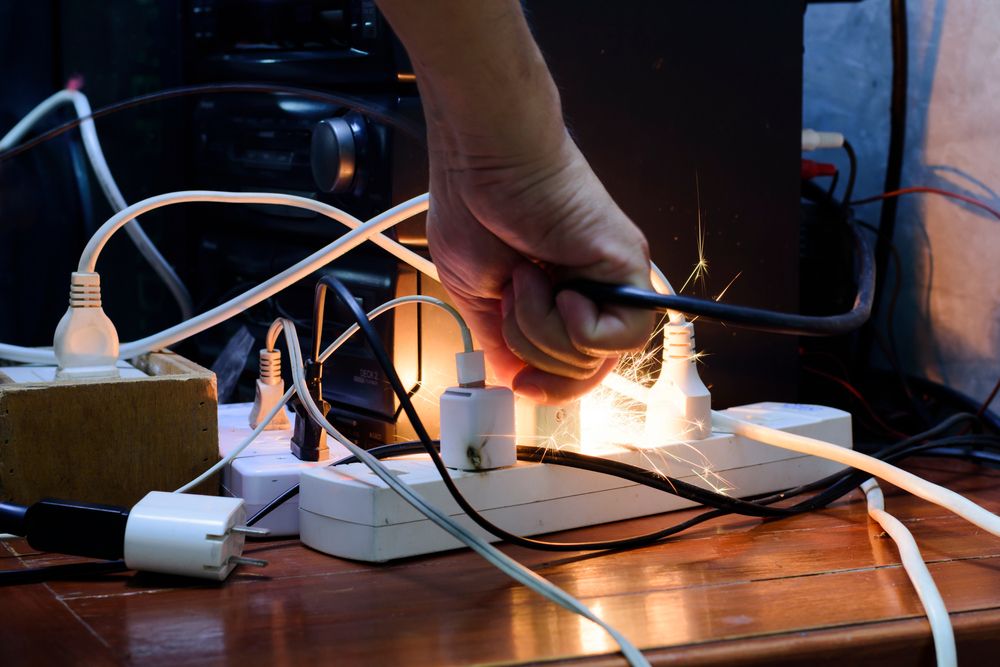

Когда какой-либо объект посещает веб-сайт, он генерирует серию запросов данных. Обычно веб-сервер может обрабатывать тысячи таких запросов и не беспокоиться. Традиционные сканеры обычно распределяют свои запросы к веб-сайтам, гарантируя, что они не перегружают и не приводят к сбою серверов. С другой стороны, веб-сканеры AI не принимают во внимание ограничения сервера.

Веб-сканеры с искусственным интеллектом обычно неоднократно обращаются к одному и тому же контенту и вместо кэширования контента пропускают его через несколько фильтров, чтобы создать картину того, что находится на веб-сайте. Более того, они склонны игнорировать инструкции в файле robots.txt, индексируя страницы, которые веб-сайт не хочет индексировать.

Обычно веб-сканеры используют заголовок User-Agent для идентификации. Веб-сканеры с искусственным интеллектом обычно этого не делают, что еще больше затрудняет их обнаружение и блокировку веб-сайтами. Системным администраторам веб-сайтов сложно ограничить эти запросы веб-сканеров с искусственным интеллектом, и им приходится полагаться на обратный поиск DNS, чтобы выяснить, какие запросы блокировать.

Как веб-краулеры с искусственным интеллектом разрушают Интернет изнутри

Почему веб-сканеры с искусственным интеллектом представляют такую угрозу? Это происходит из-за того, что они перегружают веб-трафик на страницах. Когда традиционный веб-сканер индексирует страницу, он обычно отправляет один запрос и собирает данные на основе этого запроса. Веб-сканеры с искусственным интеллектом могут отправлять до шестидесяти (или более) запросов на одну и ту же веб-страницу, что приводит к зависанию сервера во время обработки всех этих запросов.

Когда эти запросы попадают на сервер и переполняются, дело начинает двигаться медленно. Пользователи начинают получать сообщения 503 Forbidden с сервера, поскольку боты высасывают все ресурсы. Более крупные веб-сайты и дорогие пакеты хостинга могут легко справиться с этой нагрузкой путем перенаправления ресурсов. Но пара, которая на выходных только что завела хобби WordPress? Нет, этот сайт рухнет.

Почему так много сканеров с искусственным интеллектом?

Лукас Гувейя / Компьютерщик с практическими рекомендациями

Поисковые системы по-прежнему используют традиционные веб-сканеры, поскольку они усовершенствовали свой алгоритм с помощью этих инструментов. Итак, откуда же взялись новые веб-сканеры с искусственным интеллектом? Это во многом связано с технологическим пузырем искусственного интеллекта, который штурмом захватил мир. Большинство стартапов ищут уникальные и интересные способы использования ИИ, и размещение их в веб-сканерах для перекачивания данных из открытого Интернета — хорошее начало.

Парсинг веб-страниц с помощью искусственного интеллекта меняет правила игры для всего мира. С точки зрения бизнеса для сбора актуальной информации о потенциальных клиентах требуется меньше ресурсов. С точки зрения системного администратора, это означает, что их веб-сайты будут перегружены трафиком, забирая их данные и не давая им ничего взамен. Это проигрышный вариант для малого онлайн-бизнеса.

Эти малые предприятия могут потерять больше всего. Используя веб-сканеры с искусственным интеллектом для поиска на своих страницах, крупные компании могут получать информацию о своих клиентах и адаптировать продукты для их удовлетворения. В результате эти малые предприятия не могут конкурировать с натиском веб-сканеров с искусственным интеллектом. Их сайты отключаются, что делает их ненадежными. Все это время их данные перекачиваются.

Это также имеет эффект домино для таких покупателей, как вы и я. Как только товары появляются на крупных веб-сайтах, многие потребители покидают небольшие магазины, полагаясь на доставку и доставку в тот же день от более крупных розничных поставщиков. В результате небольшие магазины закрываются, и у нас остается меньше выбора. Когда есть только одно место, где можно получить то, что вы хотите, вам придется заплатить любую цену, которую вам предложат.

Как веб-мастера и системные администраторы сопротивляются

К счастью, еще не все потеряно. Некоторые системные администраторы сопротивляются. Многие веб-сканеры ИИ избегают файла robots.txt, но для тех, кто этого не делает, веб-мастера исключают страницы, которые могут предоставить этим моделям ИИ больше всего данных. Другие веб-мастера прекращают поиск пользовательских агентов, что влияет на их рейтинг SEO, но делает свои сайты более удобными для нас с вами.

Другая стратегия — использование CAPTCHA, которая требует от пользователей решить задачу, прежде чем получить доступ к определенным частям веб-сайта. Это отпугивает менее сложных ботов, в то же время позволяя законным пользователям беспрепятственно перемещаться по сайту. Веб-мастера также отслеживают журналы сервера, чтобы выявлять и блокировать проблемных ботов, игнорирующих правила. Комбинируя эти методы, веб-мастера и системные администраторы могут защитить свои веб-сайты и создать более здоровую онлайн-среду, ориентированную на удобство пользователей.

Веб-краулеры с искусственным интеллектом превращают Интернет в беспорядок

Как человек, который знает, насколько мощным является ИИ, и широко использовал его в своих проектах, я знаю, насколько он может быть полезен. Однако наряду с хорошим всегда присутствует плохое. Веб-сканеры с искусственным интеллектом являются признаком ухудшения состояния Интернета. Эти агенты собирают и анализируют данные, а затем используют их для разработки общих, бесполезных статей, которые на первый взгляд кажутся интересными, но не приносят реальной пользы нам, читателям.

Битва между системными администраторами и веб-сканерами с искусственным интеллектом, возможно, является самой важной битвой в современном Интернете, однако мало кто видит или слышит о ней. Это может быть даже больше, чем YouTube и его борьба с блокировщиками рекламы. Как заядлый пользователь Интернета, я надеюсь, что системные администраторы победят, и я смогу снова читать интересные статьи, написанные реальными людьми.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)